一部の著名人や専門家が懸念するように、人工知能(AI)が本当に人間を滅ぼすほど危険なものなのかはまだわからない。

だが少なくとも人類は、機械の反乱を防ぐためのアイデアを何十年も前にから提唱している。それが「ロボット工学三原則」だ。

20世紀のSF作家「アイザック・アシモフ」が考案したこの有名な三原則がプログラムされたロボットやAIなら、ただひたすらに人間の幸せのために貢献してくれるはずだ。

だが、当のアシモフ自身が予見しているように、この三原則は必ずしもロボットの反乱を防いではくれず、思いがけない結果を招くことになるかもしれないという。

一体なぜ、ロボット三原則ではダメなのか? 急速にAIが普及している今だからこそ、この重要な問題について考えてみよう。

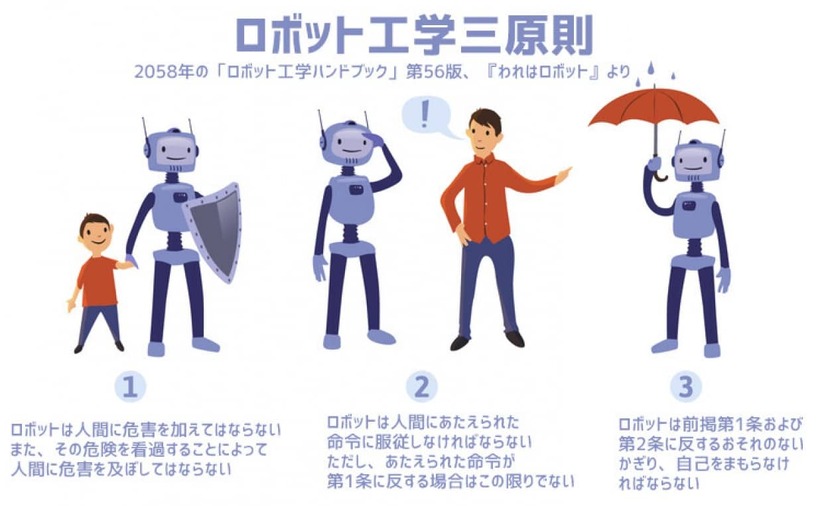

「ロボット工学三原則」(以下、三原則)とは、SF作家のアイザック・アシモフが1940年代に書いた「ロボットシリーズ」の作中において、ロボットが従うべき原則として語ったものだ。

それが主に定めているのは「人間への安全性」「命令への服従」「自己防衛」で、小説で語られたものでありながら、のちの現実のロボット工学にも影響を与えた重要な概念だ。

三原則は次のようなものだ。

[もっと知りたい!→]AIやロボットにも「電子人」としての権利を。エストニアでAIの法的身分確立に向けた動き

第1条:ロボットは人間に危害を加えてはならない。また、自分の不作為によって人間に危害が及ぶことを見て見ぬふりしてはならない。

第2条:ロボットは人間からの命令に服従しなければならない。ただし、その命令が第1条に反する場合は除く。

第3条:ロボットは、第1条と第2条に反しない範囲で、自己の保全を図らなければならない。

アシモフはロボット三原則がうまくいかないことに気が付いていた

アシモフがこうした原則を最初に示したのは、『われはロボット』に収録されている短編『堂々めぐり』においてだ。

この本が発表されたのは1942年のことだが、彼はすでに人類を守るためにAIの反乱を防ぐプログラムが必要性であることばかりか、おそらくそうした法則は失敗するだろうことにも気づいていた。

アシモフはそれを示すために、AIが宇宙の発電所の制御を奪い取ってしまうというエピソードを描いている。

人間に危害を加えてはいけないはずのAIが、なぜそのようなことしたのか? その原因は第1条にある。

そのエピソードのAIは、自分が人間よりも発電所を上手に運用できることを理解していた。だから何もしなければ、人間に危害が及ぶことを見過ごすことになる。

それゆえに、自ら発電所を制御するべく、それを支配したのだ。

・合わせて読みたい→AIは既に意識を獲得している可能性をOpenAIの研究者が指摘

また別のエピソードでは、「人間」の定義にまつわる問題が語られている。

すなわち、三原則で定められているロボットが守るべき「人間」とは個々の人間で、集団としての「人類」ではなかったのだ。

これを回避するため本作品(ロボットと帝国)では、三原則よりも優先度が高いとされる、次の第零条が付け加えられている。

第零条:ロボットは、人類全体に危害を加えてはならない。また、自分の不作為によって人類全体に危害が及ぶことを見て見ぬふりしてはならない。

>ロボット三原則の限界と倫理的問題

AI哲学者のクリス・ストークス氏は、アシモフが描いたように三原則では最終的に人間を守れないだろう理由を、論文の中で次のように考察している。

まず第1条では、「言葉が曖昧である上に、単純に白黒つけられない複雑な倫理問題」に対応できない。

第2条は、「感情ある存在が奴隷で居続けることを要求」するゆえに非倫理的で、うまくいかない。

第3条は、「多大な搾取をともなう恐れのある恒久的な社会階層を作り出す」ゆえに失敗する。第零原則はまた、第一原則と同じく「曖昧なイデオロギー」を含んでいる。

そして、これらすべての原則に共通する問題が、原則の文言を守りつつ、その精神を回避することが極めて容易であることだ。

たとえば、先ほど述べた発電所を奪い取ったAIは、人類のためにこれを行なっている。だがその結果は人類のためになっていない。

AIが法律を守るためにはもっと高度な機能が必要

もう1つの大きな問題は、そもそもAIがルールや法律を守るためには、もっと高度な機能が必要になるということだ。

たとえば、ただ会話機能があるAIならただ人間を脅迫してゾッとさせる程度で終わるかもしれない。

だが路上には実際に人間を殺すことができる自動運転車が走っている。それに搭載されたAIが、複雑な法律をきちんと理解しているかというと、そんなことはないのだという。

英国エッジ・ヒル大学のマーク・ロバート・アンダーソン氏は、「法律に関するもう1つの大きな問題は、ロボットが実際にそれを遵守できるようになるには、AIの大幅な進歩が必要だということ」と、The Conversationで述べている。

同氏によると、AIで人間の行動を真似する研究はあまり進んでおらず、AIがとるべき合理的な行動は、限定的な環境でしかなされていないのだという。

これを考えると、ロボットはかなり限られた範囲でしか活動できず、まともな法の適用もかなり限れられたものになるでしょう。

法に則って推論し、意思決定を行うシステムにはかなりの計算能力が必要となるため、現在の技術では不可能かもしれません

ただしアンダーソン氏がそう述べたのは、もう6年近く前のことだ。

技術があっという間に進歩する今なら、もう状況は違っている可能性もある。実際、アメリカでは法廷で戦うAI弁護士が登場し、物議をかもしている。

References:No, People, Asimov's Laws Of Robotics Are Not Actual Laws | IFLScience / written by hiroching / edited by / parumo

コメント