米スタートアップのOllamaは現地時間7月30日、手軽にローカルLLMを扱える新たなアプリを公開したことを発表した。同社公式サイトからWindows/Mac対応でダウンロードできる。コア部分のソースコードv0.10.0はGitHubに設置してある。

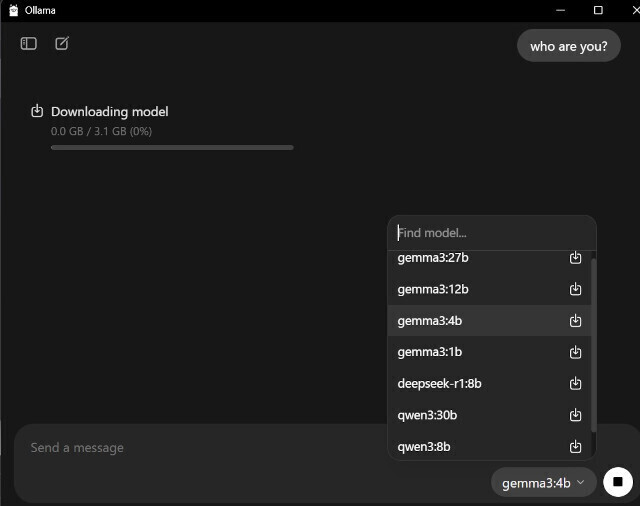

6月にGoogleの軽量・高性能なマルチモーダルAIモデル「Gemma 3」に対応するv0.9.3、ネットワーク経由でのアクセスを可能とするv0.9.5などバージョンを重ねるOllamaの最新版v0.10.0では、Gemma 3モデルのパフォーマンスを数倍向上させており、今回公開したWindows/Mac向けのバイナリでは、ファイルのドラッグ&ドロップや画像をサポートするチャットなどマルチモーダルを使った機能が追加。LLMの追加や交換もGUI上で行えるなど使いやすさが向上している。

.

(長岡弥太郎)

コメント